Introduzione: Sapphire–>

Nei mesi scorsi, abbiamo avuto modo di provare con mano e spingere ai loro limiti praticamente l’intera lineup di Sapphire (esclusa la R9 295X2 che ancora aspettiamo. Capito mamma Sapphire?), partendo dalla Sapphire Radeon R7 250 fino ad arrivare alla mastodontica, velocissima e gelida Sapphire Radeon R9 290X Vapor-X Tri-X OC da 4GB. Fate attenzione a questo numero: 4GB. Siamo “cresciuti” un po’ tutti con il mito che “una scheda video con più VRAM va più veloce di una con meno VRAM”, anche se questa frase è una vera e propria automazione da lobotomia che i commessi nei centri commerciali ci hanno propinato ogni volta per vendere un PC all’inesperto di turno.

Oggi, invece, vi dimostriamo come, in alcune situazioni specifiche e con alcuni modelli, a parità di GPU una scheda video con più VRAM riesce ad eseguire più fluidamente alcuni titoli. Recensiamo oggi, quindi, la Sapphire Radeon R9 290X Vapor-X Tri-X da ben 8GB. Buona lettura!

Sapphire Radeon R9 290X Vapor-X Tri-X OC 4GB: specifiche tecniche–>

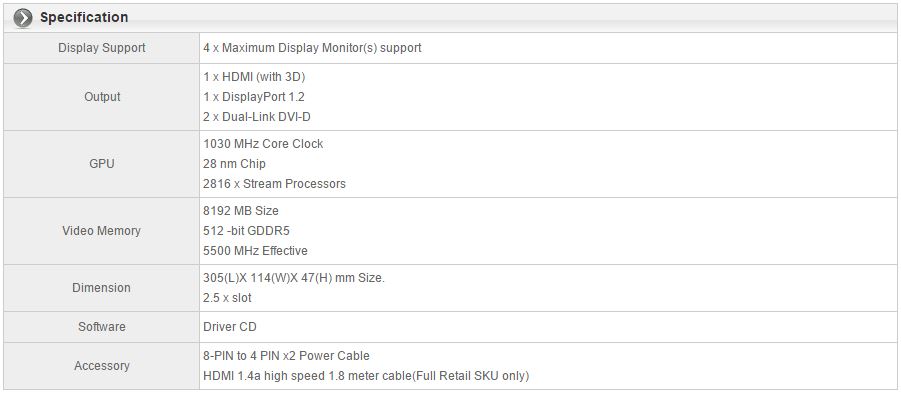

Di seguito, la tabella delle specifiche tecniche della scheda video, ulteriori informazioni sono consultabili in versione integrale sul sito ufficiale del produttore (Sapphire):

Forte di un design totalmente personalizzato, la 290X oggi recensita presenta un PCB totalmente rivisto, un dissipatore che si basa sul Tri-X (avvalendosi però della rinomata tecnologia di Sapphire Vapor Chamber) e clock maggiori rispetto al modello reference, senza appunto dimenticare una dotazione di memorie doppia rispetto alla versione standard, per un totale di 8GB di GDDR5 clockate a 5500 MHz. La scheda, portando con sé la GPU Hawaii XT, dispone di 2816 Stream Processors abbinati alla suddetta RAM video tramite un bus a 512 bit.

La GPU non presenta clock reference, infatti la freq. operativa è di 1030 MHz, pressoché costanti, a differenza del modello base che vede un clock massimo di 1000 MHz ma che per via del Thermal Throttling non vengono raggiunti se non nei soli primi minuti di utilizzo della scheda. Le dimensioni sono generose, e infatti visti i 2.5 slot occupati da ogni scheda consigliamo una mainboard con gli slot PCI-E ben distanziati qualora voleste optare per una configurazione CrossFireX.

Il pannello di connessioni, infine, rimane invariato, con una doppia porta DVI-D Dual-Link, una porta HDMI 1.4a ed una DisplayPort 1.2.

Hawaii: architettura nei dettagli–>

Potremmo assimilare l’architettura utilizzata dalla GPU Hawaii (XT e Pro) in un GCN 1.1, come viene definito da AMD stessa. La potenza per mm2 è del 5% maggiore rispetto alla precedente generazione (ovvero quella su cui si basano le VGA HD7000). Per capirci, le soluzioni tecniche sono le stesse adottate dalla GPU HD7790 (recensita da noi QUI), ovviamente portando il tutto in grande scala viste le dimensioni mastodontiche del chip utilizzato sulla 290X/290: si parla di ben 6,2 miliardi di transistors in un package di 438mm2, con un aumento del ben 24% rispetto alla precedente generazione. nVidia, con il suo GK110, arriva ad addirittura 7.1 miliardi, ma con una superficie ben superiore. La densità di transistors è, pertanto, di gran lunga superiore. Andiamo quindi ad analizzare nel dettaglio l’architettura della scheda:

Parlando ad alto livello la scheda presenta un aumento negli Stream Processors di ben 768 unità, un aumento della Cache L2, insieme all’introduzione di nuovi componenti. Sul die della GPU, infatti, è integrato anche il nuovo DSP TrueAudio responsabile della gestione audio nei videogames, ma di questo parleremo in una delle prossime pagine. Troviamo i nuovi motori xDMA che gestiscono il CrossFireX di tipo “bridgeless” (ovvero senza la necessità di utilizzare un ponte esterno per collegare le schede), insieme ai nuovi motori di gestione EyeFinity che consentono di pilotare navitamente 6 schermi con una sola scheda, in configurazione 3×2. È facile intendere che non ci troviamo di fronte ad un’architettura totalmente nuova; piuttosto, ci troviamo di fronte ad un “refresh” della già molto efficiente GCN, con una riorganizzazione dello spazio sul die, grazie al quale è stato possibile inserire un bus da 512 Bit occupando meno spazio del bus da 384 Bit di Tahiti XT, il tutto senza perdere prestazioni, grazie a 8 collegamenti da 64 Bit ad alta efficienza.

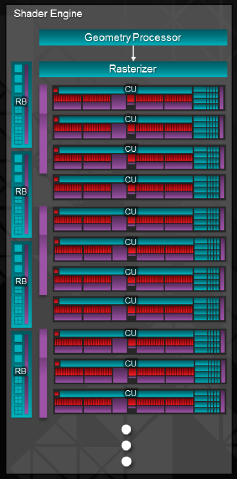

La Compute Unit (CU) di Hawaii si presenta uguale a quella di Tahiti, che fa dell’elevata efficienza di calcolo rispetto allo spazio occupato il suo punto di forza. Al pari di Tahiti, infatti, ogni CU può gestire calcoli in maniera autonoma rispetto alle altre, ottimizzando quindi la parallelizzazione nei calcoli disegnati per tale tipo di computing. Dalla prospettiva del thread processing, ogni CU dispone di 4 sub unità vettoriali (denominate SIMD) composte ognuna da 16 Stream Processors, per un totale di 64 SP per CU. Questo schema è supportato da 4 Texture Units e 16KB di cache L1 a lettura e scrittura esclusiva della CU. Insieme ad ogni unità vettoriale (VU) indipendente, AMD ha associato uno scheduler ad alto bandwidth, che lavora insieme alla cache unificata (di L2) e alla cache dedicata ad ogni CU, facilitando la condivisione dei dati attraverso le linee dati. In soldoni, esso funge da semaforo indirizzando correttamente i flussi dati. Un’altra parte importante nella gerarchia delle CU è la presenza di unità scalari (SU) con registri dedicati. Questa sub-unità funge da core programmabile di tipo general purpose, facendosi carico di una parte dei calcoli di alcune aree delle CU, o lavorando indipendentemente se necessario, come se fosse un vero e proprio processore associato ad ogni CU. Nessuno di questi moduli è stato cambiato da Tahiti, tuttavia è stata migliorata ulteriormente l’efficienza in caso di calcoli logaritmici o esponenziali di tipo 1ULP, ovvero quando si compiono operazioni in FP. Hawaii porta con sé il supporto al MQSAD (masked quad sum of absolute difference) e Shaders compatibili con lo standard IEEE-2008, insieme ad una serie di cambiamenti nella queue di processi:

La stragrande maggioranza di miglioramenti è stata implementata negli stadi di processing della geometria, requisito necessario per supportare e calcolare correttamente i set di istruzioni contenuti nelle DX11.2 e nelle Direct3D 11.2. Al posto dei due Geometry Engine, ora ci sono ben quattro GE, consentendo di gestire 4 primitive concorrenti ad ogni ciclo di clock. Questa novità è gestita senza problemi grazie alle capacità di caching maggiorate (in particolar modo, la cache di L2 R/W è stata aumentata a 1MB, con ben 1TB/s di banda passante per le comunicazioni tra le cache di L1 e L2). Ulteriori miglioramenti sono stati applicati on-die, grazie ad un front-end di caricamento e salvataggio incrementato, il quale è utilizzato per velocizzare le comunicazioni tra le varie unità di calcolo e la memoria. AMD, finalmente, ha migliorato con questo meccanismo il buffering tra GPU e memorie, consentendo così di aumentare il throughput di tassellazione, cosa che era il punto debole della precedente architettura.

Ogni CU, Geometry Processor e Rasterizzatore, insieme a 4 Back-End di renderizzazione individuali, insieme ad altri elementi secondari, sono combinati in un’unica unità organizazzionale denominata Shader Engine. Ogni Shader Engine dispone di 704 SP (divisi in CU di 64 SP ciascuna), 44 Texture Units e 16 Rop. Lo Shader Engine, per intenderci, è paragonabile al Graphics Compute Unit di nVidia, con la differenza che AMD ha aggiunto RB (Rendering Back-Ends) indipendenti dalla gerarchia delle memorie. Con questa riorganizzazione, AMD ha raccolto le risorse in questi engine in modo da facilitare le comunicazioni inter-cores. Per esempio, mentre tutte le cache degli engine possono essere condivise da 4 Compute Engines ciascuna, parallelamente gli RB sono configurabili in modo da assistere suddetti CE o in modo da gestire calcoli del tutto indipendenti e scollegati.

Il throughput di calcolo, inoltre, è stato indirizzato tramite 8 ACE (Asynchronous Compute Engines, Motori di Calcolo Asincroni) al posto dei 2 di Tahiti. Non solo hanno accesso diretto alla Cache L2 e ai Data Stream gestiti da tutte le unità di calcolo, ma possono anche gestire 8 code di calcolo. Prima di passare per gli engine DMA, i dati elaborati dagli ACE passa per il memory controller. In particolare, i motori DMA sono in grado di saturare il bus bidirezionale di uno slot PCI-E 16x di tipo 3.0, tuttavia le prestazioni computazionali di questa particolare architettura non giungeranno mai a richiedere tutta quella banda passante, in quanto la maggioranza dei calcoli viene effettuata direttamente dalla GPU.

Hawaii: gestione dei clock dinamica–>

Con entrambe AMD e nVidia a spremere dal processo produttivo a 28 nm quante più prestazioni possibili, entrambe hanno combattuto per ottimizzare i consumi energetici e la produzione di calore. La tecnologia PowerTune fu lanciata da AMD per contenere questi tre fattori (prestazioni, energia, calore) entro limiti modificabili solo tramite overclock. Con questo metodo, sia i consumi che le prestazioni venivano limitate, ma a differenza del GPU Boost di nVidia, non teneva in considerazione le infinite variabili intorno ad esso, come le temperature e l’overhead di potenza assorbibile. Un esempio esplicativo è, ad esempio, il differente approccio alle frequenze tra una HD7970 GHz Edition ed una GTX 780. La scheda AMD spinge le frequenze a 1050MHz indipendentemente dalla temperatura della GPU, mentre la GTX 780, d’altro canto, ha la possibilità di sfruttare l’ottima dissipazione termica del proprio design reference (e non solo) portando la GPU a clock incredibilmente superiori, rispetto all’irrisorio aumento che ritroviamo nelle schede “rosse”. Con le R9-290/R9-290X, AMD mette da parte questo approccio arcaico e anziano, implementando un nuovo modello di bilanciamento tra prestazioni ed efficienza.

Fondamentalmente, la “filosofia” alla base del PowerTune è rimasta la stessa (ovvero, performance legate strettamente al consumo energetico), ma AMD ha aggiunto una serie di features volte a gestire in modo ottimale il clocking dinamico della scheda, prendendo spunto soprattutto dal segmento APU, in cui AMD sta avendo un discreto successo. Così come la precedente iterazione del PowerTune, i sensori di temperatura e attività sono sparsi sulla GPU per determinare quanta corrente effettivamente viene utilizzata da essa. In precedenza, molti di questi valori venivano stimati, pittusto che calcolati alla fonte. AMD, con questa iterazione, ha aggiunto un gruppo ulteriore di sensori, che monitora attivamente l’ammonto effettivo di energia assorbita, il tutto tramite i VRM della scheda. Questi dati vengono poi combinati con i valori stimati, in modo da “triangolare” i valori effettivi e il “fabbisogno energetico” della scheda. Grazie alla telemetria energetica e termica che confluisce nell’arbitratore di gestione dinamica di potenza (DPM Arbitrator), il nuovo PowerTune può finalmente effettuare scelte basandosi su dati raccolti in tempo reale, piuttosto che su supposizioni. In questo modo, ad AMD è permesso di impostare le migliori frequenze possibili da quella combinazione di energia consumata, temperature e velocità della ventola. Ciò significa che è possibile a stati diversi di questi tre fattori frequenze simili. Uno dei fattori cruciali nel nuovo PowerTune è il fatto che ora all’utente viene data piena libertà sulla personalizzazione delle curve di gestione del sistema. In soldoni, se volete una scheda silenziosa ma fresca potete abbassare la velocità e i clock per ottenere consumi minori e quindi temperature inferiori, o potete ignorare la rumorosità ed avere il massimo consumo energetico e clocking che la scheda permette. Finalmente, all’utente viene dato il controllo totale della gestione di questi parametri.

La seconda generazione di regolatori di tensione, utilizzata su questa famiglia di GPU, permette di bilanciare dinamicamente tutti gli aspetti dello spettro energetico della scheda. Il controller si assicura di mantenere il consumo energetico entro un limite dello 0.5% di varianza rispetto ad un target di potenza, refreshando voltaggi e frequenze fino a 500 volte al secondo. In questo modo, aumenta la granularità delle frequenze, senza picchi e valli nella gestione dei clocks. La parte migliore di tutto ciò è che sarà totalmente personalizzabile, tale gestione, consentendo il controllo dei parametri operativi tramite il software AMD.

Ovviamente, tutto ciò che abbiamo detto finora fa assumere alla ventola un valore tutt’altro che marginale nell’equazione del nuovo PowerTune. Precedentemente, il controller integrato regolava la velocità della ventola in modo “scripted”, mentre adesso il fan controller è completamente dinamico, gestendo in tempo reale e in maniera predittiva la velocità delle ventole, senza sbalzi di velocità, ma con curve meno aggressive.

Hawaii: Eyefinity reinterpretato–>

Mentre Eyefinity può non essere una prerogativa della maggioranza dei gamers, i pochi che utilizzano 3 o 6 schermi formano un gruppo esigente di utenti enthusiast. Sfortunatamente, in passato, utilizzare una singola scheda per una configurazione Eyefinity rappresentava un limite per via delle connessioni miniDP presenti nel pannello di uscite, visto che era necessario utilizzare uno di essi per gestire tre monitor o più. Ciò significava comprare un monitor con tale ingresso o comprare adattatori di tipo to Display Port, che presentano comunque un costo non proprio contenuto.

Sulle nuove R7/R9, all’utente verrà lasciata la possibilità di pilotare 3 schermi senza passare dalla porta DisplayPort, anche se c’è da dire che a parte la R9-290X e la R9-290, nessuna scheda ha abbastanza potenza per gestire 3 monitor da 1920×1080 Pixel, a meno che non utilizziate più schermi per motivi di lavoro e non per giocare ad altissima risoluzione. Tali funzionalità permangono anche nelle schede di fascia bassa della

serie R7, in modo da permettere a chiunque voglia una soluzione multi-schermo, senza per forza di cose spendere tanti soldi in una scheda da gaming, aumentando la produttività lavorativa senza appunto sborsare molto.

Molte schede appartenenti alla serie R sono equipaggiate con 2 connettori DVI-D, una porta HDMI 1.4a ed una DisplayPort 1.2. Mentre è possibile utilizzare infinite combinazioni di schermi, alcune R9-280X saranno equipaggiate con un layout leggermente diverso, ovvero due mini DP al posto della singola DisplayPort. In quel caso, il supporto esteso ad Eyefinity tramite HDMI e DVI semplifica di gran lunga le cose. Fate attenzione: abbiamo parlato di connettori DVI-D sulle 290/290X, ovvero non sono presenti i pin necessari agli adattatori DVI-to-VGA, lasciando tale prerogativa alle schede di fascia inferiore.

Per l’Eyefinity a 6 schermi, il connettore DisplayPort 1.2 delle nuove schede consente di pilotare un hub MST (Multi Stream Transport) in modo da “spezzare” un singolo segnale DisplayPort in tre segnali differenti di qualsiasi tipo, creando una “daisy chain” con gli altri 3 connettori della scheda.

Hawaii: TrueAudio, innovazione a 360°–>

Pensando ai videogiochi in relazione alle schede video, la prima cosa che balza alla mente è la velocità di elaborazione dell’enorme quantità di dettagli a schermo, insieme alla qualità di tutto ciò. Tuttavia, il fotorealismo determina solo in parte l’immersione del giocatore nel proprio titolo preferito, ed un’altra buona parte di tale immersione è data dal sistema audio alla base dei giochi, aspetto spesso sottovalutato e talvolta cruciale nel coinvolgimento totale del player nelle scene renderizzate. La qualità effettiva dell’audio multicanale posizionale occupa un ruolo fondamentale nell’immersione del giocatore, ma spesso le soluzioni disponibili al momento non soddisfano gli standard imposti dalla qualità grafica. Insomma, per quanti milioni di dollari uno sviluppatore spenda in un titolo videoludico, non troveremo mai colonne sonore ai livelli di Hollywood, come, per fare un esempio concreto, le musiche di Hans Zimmer in Inception.

Nonostante l’assenza di tracce audio ad alta qualità da parte degli sviluppatori, i tentativi non mancano. Infatti, i middleware e i software capaci di semplificare il lavoro del rendering audio sono già presenti sulla piazza, ma gli sviluppatori hanno un ammontare limitato di risorse CPU con cui lavorare. Fondamentalmente, la maggior parte della CPU viene impegnata per la gestione del programma, dell’AI, della fisica, dei calcoli, del corretto indirizzamento dei dati alla scheda video e a tutta una serie di meccanismi invisibili al giocatore. Come è lecito aspettarsi, l’audio occupa approssimativamente solo il 10% delle risorse presenti nel sistema, non ricevendo le attenzioni che merita. Ed è qui che TrueAudio entra in scena. Mentre la scheda audio e altre forme di renderers audio esterni possono scaricare una parte del lavoro da parte del processore, in fin dei conti non si occupano della vera e propria produzione dell’audio, e TrueAudio, rimanendo in background, agisce come “facilitatore” del carico del rendering audio e della creazione del suono, permettendo, parlando dalla prospettiva dello sviluppo, di liberare risorse CPU per altri compiti. TrueAudio è una pipeline audio ad alta programmabilità e permette di decodificare, codificare, mixare e gestire tutti gli aspetti sonori con un’elevata versatilità, permettendo agli sviluppatori di indirizzare altrove le risorse impegnate per la creazione dell’audio di un gioco. Per contestualizzare il ruolo di TrueAudio, potremmo paragonarlo allo sviluppo di un motore grafico. Gli ingegneri del suono e i programmatori, di solito, registrano suoni dal mondo reale mixandoli poi insieme, combinando vary layers, per creare un dato effetto. Il giocatore ha bisogno di udire uno sparo? Registralo e mixalo di conseguenza. C’è molta poca flessibilità, non si ha a che fare con poligoni e triangoli e texture. TrueAudio permette ai team assegnati allo sviluppo audio di semplificare tali operazioni, fornendo algoritmi personalizzati senza preoccuparsi dell’overhead della CPU, in modo da produrre audio ad alta fedeltà senza incorrere in un hardcap di risorse del processore.

Secondo AMD, una delle migliori caratteristiche del TrueAudio è la trasparenza fornita agli sviluppatori, visto che l’accesso alle risorse da esso predisposte è identico a quello che si effettua tramite le attuali risorse audio. Nessun nuovo linguaggio, nessun programma di terze parti per reindirizzare le risorse, tutto avviene automaticamente, lasciando piena libertà ai tecnici audio. La posizione di TrueAudio all’interno dello stack audio migliora la sua percezione, facendolo inquadrare come un meccanismo facilitante di tutta la gestione sonora, grazie al fatto che tutto ciò che fa avviene in background. Le tracce audio con un supporto alla tecnologia vengono passate al motore TrueAudio on-die, tornando poi alle risorse Windows Audio, in modo da poter essere riprodotto come qualsiasi altra fonte sonora, sia essa attraverso la scheda audio, una porta USB o una connessione HDMI/DisplayPort. Non prende il posto della scheda audio, sia chiaro, ma permette che l’audio codificato abbia una qualità maggiore con un impatto pari allo 0% sulle risorse di calcolo celntrali.

TrueAudio è implementato direttamente nelle schede grafiche che lo supportano (HD7790, R7-260X, R9-290 e R9-290X) tramite un set di core DSP dedicati (Tensilica HiFi EP) localizzati direttamente sul die della GPU. Questi core verranno dedicati al processing dell’audio nei giochi, calcolando fonti sonore sia a virgola fissa che a virgola mobile, dando significanti aumenti di libertà alle software house rispetto ad ora. Tali cores si occupano anche di gestire il processing audio, slegandosi totalmente dai cicli di calcolo del processore centrale. Per assicurare un accesso rapido e senza ritardi, i DSP dispongono di un accesso rapido alla memoria locale, grazie alla cache on-board e alla RAM. Inoltre, un set di istruzioni condivise dal motore DMA aiuta a processare l’audio attraverso i vari stadi. Ancora più importante, l’output dei calcoli effettuati da tali DSP è collegato direttamente alle pipeline dei display, in modo da “non rimanere indietro” rispetto alle risorse grafiche. Mentre TrueAudio assicura che il processing dell’audio venga effettuato sui DSP dedicati piuttosto che sui core grafici, è comunque possibile implementare i calcoli effettuati dalla CPU, alleggerendo comunque il carico, o mantenendolo inalterato, aumentando al contempo l’immersione sonora.

Una delle sfide maggiori per gli ingegneri del suono è la creazione di un audio tridimensionale attraverso cuffie stereofoniche. In un setup tipico, il motore ingame effettua il processing iniziale, mixando poi le tracce in un semplice segnale stereo. I DSP secondari addizionali, di solito posizionati sull’amp USB delle cuffie, si occupano poi di renderizzare la traccia in un surround virtuale su due canali, aggiungendo riverberi, separazioni e altri “trucchi” per creare virtualmente un suono posizionale. Il risultato, spesso, è mediocre, in quanto l’audio tende a perdersi più che a definirsi di più. TrueAudio assiste la virtualizzazione, offrendo script preimpostati per il processing. Viene utilizzato un DSP ad alta qualità che assicura che ogni singolo canale audio venga separato e indirizzato in una propria pipeline dedicata. AMD ha collaborato con GenAudio per consentire ciò, e dalle slide viste finora, sembra che abbiano creato qualcosa di davvero incredibile.

Mentre dal lato dello sviluppo nulla cambia, questa nuova addizione permette non solo un’ottimizzazione delle risorse CPU. Effetti avanzati, uno stadio sonoro più ricco, tracce vocali più chiare e molto altro ancora può essere gestito grazie al minor overhead e al supporto esteso alle applicazioni già esistenti. In aggiunta, i limitatori di mastering permettono ai suoni individuali di essere riprodotti senza distorsioni. A differenza di alcune applicazioni, TrueAudio non è una magica sfera di cristallo che risolve tutti i problemi del mondo, in quanto è progettata per tracciare come obiettivo flussi ad alta definizione, in modo che non tutte le fonti audio vengano elaborate da esso. AMD non taglia fuori la CPU dall’equazione di calcolo, piuttosto fa in modo da creare un ambiente di calcolo eterogeneo e con ruoli specifici per ogni unità di elaborazione.

Come con tutte le iniziative, il fallimento o il successo di TrueAudio dipenderà soprattutto dal desiderio degli sviluppatori di supportarlo o meno. Per quanto possa sembrare un “deja-vu” come con HD3D, Bullet Physics e altri concetti di marketing di AMD degli anni passati da cui non si è mai schiodata, è molto probabile che TrueAudio sia una soluzione che riuscirà a brillare. Gli sviluppatori sono già al lavoro, e AMD ha sofferto molto per rendere il processo di sviluppo quanto più friendly possibile. L’audio è una delle poche frontiere che non è stata ancora esplorata; tutto ciò che migliora l’audio nell’esperienza dei PC è la benvenuta, ma non aspettatevi miracoli. Molto probabilmente le vostre cuffie e le vostre schede audio non avranno cambiamenti sostanziali, ma sistemi più grandi, setup più potenti, potranno avere finalmente la giustizia che meritano. AMD ridefinisce, in pratica, l’audio con le proprie schede video.

Hawaii: Mantle, asso nella manica?–>

Per capire da dove proviene Mantle, dobbiamo tornare indietro nel tempo e prendere la PlayStation 3 come esempio di come AMD vuole cambiare il modo in cui i giochi interagiscono con il sistema grafico del PC. Mentre il processore Cell della PS3 e i core grafici associati sono difficili da programmare, giochi come Uncharted 3 e The Last of Us portano con loro una grafica migliore a molti titoli PC recenti, nonostante l’hardware di oggi sia qualcosa di inimmaginabile, rispetto all’hardware di lancio della console. Come è possibile? Le console danno agli sviluppatori un accesso facilitato al sottosistema grafico, senza driver grafici, overhead prodotto dalle API, un OS che ostruisce e altre eccentricità non necessarie che divorano risorse importanti. Il risultato è che i giochi per console sono capaci di utilizzare al 100% una risorsa data, permettendo ai programmatori di fare di più con meno. In alcuni casi (la PS3 è ancora un esempio che calza a pennello) il passaggio che consente di utilizzare appieno tali risorse come programmatori richiede un approccio totalmente diverso ad una piattaforma hardware, reimparando, di fatto, a programmare. Qui, interviene AMD a rendere il processo meno arduo ed accessibile a tutti.

Mantle è stata creata per ridurre il numero di ostacoli tra gli sviluppatori e ciò che vogliono creare quando creano un nuovo gioco o quando vogliono effettuare un porting dalle consoles. In passato, cose come l’ottimizzazione della CPU e l’efficienza nella comunicazione tra componenti erano categoricamente ignorate, con gli sviluppatori alle prese con un’infinità di configurazioni hardware possibili, con CPU multicore non sfruttate a dovere, risorse GPU sprecate e la mancanza di un’ottimale condizione prestazionale sul PC, malgrado l’hardware più avanzato. C’è inoltre una larga componente software nell’ambiente PC, in quanto i programmatori, per accedere alle risorse, devono passare da software, sistemi operativi e driver che comunque inspessiscono la distanza tra loro e l’hardware. Ciò è un problema di non poco conto, che porta all’interazione software-memoria a quella che potrebbe essere paragonata ad un semaforo con il verde che dura pochi secondi, come un collo di bottiglia che limita il throughput computazionale. Le DirectX 10 e 11 hanno cercato di indirizzare nella maniera corretta molti di questi blocchi, ma le prestazioni generali sono comunque ancora limitate dal fatto che sono API ad alto livello. Insomma, la comunicazione da loro gestita tra API, GPU, gioco e CPU è ancora forzata in canali stretti, qualcosa che gli sviluppatori non vorrebbero trovarsi davanti. Utilizzando API ad alto livello (come, appunto, DX10 e 11), vengono effettuate un elevato numero di chiamate di drawing, che portano inevitabilmente a saturare i cicli di calcolo della CPU: in pratica, le architetture grafiche odierne non possono esprimere tutto il loro potenziale.

Qui interviene Mantle, con la sua introduzione nell’equazione: non un rimpiazzo diretto delle DX e delle OpenGL, ma una forza complementare ad esse. Essa è un’API che si focalizza sul metallo nudo e crudo, programmazione a basso livello con un driver leggerissimo, che gestisce efficacemente la distribuzione delle risorse, garantisce controlli addizionali sull’interfaccia della memoria grafica e ottimizza le suddette chiamate di drawing. Pensate di Mantle come un mitragliamento a bassa quota che bersaglia componenti chiave, piuttosto che un bombardamento a tappeto che non garantisce pienamente che un obiettivo venga colpito. Con una linea di accesso più diretta alla GPU, AMD spera che le performance di GCN aumentino drasticamente, incrementando l’efficienza piuttosto che mettere alla base del problema una maggiore potenza grezza. Aprire a nuove tecniche di rendering che non sono legate alle API odierne è una possibilità. Teoricamente, ciò permette a Mantle di processare chiamate di drawing superiori del 900%, e ancor più importante, permette di portare giochi da console a PC e viceversa con tutte le ottimizzazioni delle risorse del caso.

Ovviamente, ci sono delle limitazioni per questo approccio. Mentre le API di alto livello rimarranno le stesse (DX, D3D) tra le varie aziende hardware, Mantle sarà compatibile solo con GCN. Questa è un’ottima notizia per tutti coloro che utilizzano una scheda HD7000 o superiore o chi possiederà una nuova console, ma gli utenti in possesso di schede GeForce o Intel HD4000 verranno lasciati fuori, in quanto almeno per il momento né nVidia né Intel hanno soluzioni paragonabili o compatibili. Persino le schede precedenti a GCN sono state messe da parte in favore del progresso. Con ciò a mente, gli sviluppatori potrebbero essere costretti a bypassare il supporto a hardware non recente, aggiungere Mantle come opzione selezionabile o semplicemente ignorare Mantle finché i prodotti compatibili siano fuori commercio. Senza dubbio AMD ha vinto la corsa alle prossime generazioni di console, grazie alle APU Jaguar su entrambe XOne e PS4, cosicché questi design facciano parte integrante della loro strategia futura. Purtroppo, è stato detto davvero molto poco riguardo alle API ad alto e basso livello utilizzate in questi prodotti, in primis l’Xbox One, le Direct3D 11.2 sono date per scontate, ma nessuno sa di cosa si tratti scendendo al basso livello. Microsoft ha anticipato tutti dicendo che Mantle non verrà utilizzata come API a basso livello, ma includendo la compatibilità HLSL DirectX di cui dispone la console potrebbe far avverare i sogni dell’azienda a lungo termine. Sotto molti aspetti, questo approccio ci ricorda le Glide di 3DFX, un’altra API a basso livello sviluppata anni fa ma fallita miseramente per la mancanza del supporto di sviluppatori e per la dismessa dell’azienda che le creò, 3DFX, appunto. Una delle maggiori sfide nel fare qualcosa al di fuori dei tipici ambienti DX/OpenGL è vendere l’idea agli sviluppatori. Mantle può aver mostrato promesse senza fine, ma abbiamo visto già una pletora di tecnologie simili messe da parte per via di uno scarso supporto dall’industria. Stavolta, però, AMD ha sostenitori di grande rilievo già dal day one.

Se AMD avesse utilizzato un piccolo studio di sviluppo per diffondere le proprie API, molti poche aziende l’avrebbe presa sul serio. Invece, hanno raggiunto subito credibilità grazie al supporto di EA e, di conseguenza, di DICE. Una combinazione responsabile della creazione della serie multimiliardaria di BattleField, considerata un caposaldo dell’industria dei videogiochi. Secondo Johan Andersson, Lead Designer di DICE ed evangelista rispettato della tecnologia avanzata del PC, Mantle è uno sforzo collaborativo tra AMD, EA, DICE e altri studios. Il risultato è che il Frostbite 3 di DICE supporterà nativamente le nuove API a basso livello. È un affare non di poco conto, se considerate il largo numero di titoli tripla A che useranno tale motore. Need For Speed: Rivals, Dragon Age: Inquisition, Star Wars Battlefront, BattleField 4, sono tutti titoli che utilizzeranno il Frostbite 3 e che potrebbero potenzialmente includere un’opzione per Mantle. Gli altri sviluppatori seguiranno a ruota visto che Mantle è stata creata per soddisfare le esigenze di essi, quando ci si trova di fronte alla creazione di un titolo PC o di un porting.

Il primo titolo ad includere il supporto a Mantle sarà l’incredibilmente anticipato Battlefield 4. Comunque, Mantle verrà diffuso solo in una patch di Dicembre, due mesi dopo il rilascio iniziale, avvenuto proprio pochissimi giorni fa. Ciò pone ottime basi in quanto dimostra che Mantle può essere implementato in un gioco con una patch, senza stravolgere il codice sottostante e offrendo al pari del Source Engine un’opzione di switching tra le modalità di rendering. Ovviamente, siamo fortemente interessati ai boost prestazionali che può fornire rispetto ai competitors. Considerando tutto ciò, dove si colloca Mantle nel panorama attuale delle API? Non ne siamo ancora sicuri, visto che la tecnologia è ancora ai primi stadi. A giudicare dalla reazione dei siti internet in giro per il mondo sul suo annuncio, gli sviluppatori già aspettano con clamore di avere accesso alle versioni per PC. Un segno incoraggiante, insomma. Comunque sia, come Mantle si evolverà attraverso la sua iterazione attuale dipende dal desiderio di AMD di supportarla negli anni a venire, ed è qui che si pone un grande punto interrogativo. Vista l’associazione vicina alle console e all’abilità di facilitare i porting su e da PC, dal punto di vista di sviluppo ed ingegneria hardware, dovrebbe essere una scelta ad occhi chiusi, quindi ci sono ottime speranze che il supporto non verrà tagliato molto presto, anzi, si prospettano ottime applicazioni per quest’API.

Mantle e il suo lancio ci dicono un bel po’ di cose: il rapporto di AMD con gli sviluppatori inizia a ripagare concretamente, l’inclusione dell’architettura GCN sulle console di next-gen si sta mostrando un fattore molto più cruciale di quanto nVidia ha cercato di far pensare, e AMD stavolta è seria da morire sulla focalizzazione sul gaming. Mantle è un filone comune che connette così tante iniziative che può essere davvero l’occasione di AMD di far brillare tutto ciò che è presente nel suo portfolio, dalle prossime APU Kaveri alle GPU discrete alle console. Ulteriori informazioni verranno divulgate durante l’AMD Developer Summit che avrà luogo questo mese.

Galleria fotografica: Sapphire Radeon R9 290X Vapor-X Tri-X OC 8GB–>

Esteticamente, se non nella confezione, la scheda è identica al modello da 4 GB. Pertanto, utilizzeremo le stesse immagini:

Configurazione di prova e metodologia di test–>

La configurazione utilizzata per i test è la seguente:

| CPU | Intel Core i7 5960x @ 4.5GHz |

|---|---|

| Heatsink | Swiftech H220-X AIO Liquid Cooling |

| Mainboard | ASRock X99 OC Formula |

| RAM | Corsair Vengeance LPX 16 GB 2666 MHz DDR4 |

| VGA | Sapphire AMD Radeon R9 290X Tri-X Vapor-X 8GB |

| Sound Card | Integrata |

| HDD/SSD |

|

| PSU | Corsair HX1000i |

| Case | Corsair Graphite 780T Arctic White |

| Monitor | EIZO FlexScan EcoView EV2736WFS |

| Keyboard | Corsair Gaming K70 RGB |

| Mouse | CM Storm Havoc e XTRFY XGP1-L4 |

| OS | Windows 8.1 Pro x64 |

Si ringraziano ASRock e Corsair per le componenti utilizzate nella configurazione di prova.

Visto l’upgrade lato configurazione, abbiamo deciso di portare dei piccoli cambiamenti ai benchmark utilizzati:

- Unigine Heaven Benchmark 4.0

- Futuremark 3DMark Fire Strike

- Futuremark 3DMark Fire Strike Extreme

- Futuremark 3DMark Fire Strike Ultra

- AllBenchmark CatZilla

- Thief (2014) (Benchmark integrato)

- Bioshock Infinite (Benchmark integrato)

- Metro Last Light (Benchmark integrato)

- Terra di mezzo: Ombra di Mordor (Benchmark integrato)

Ringraziamo Futuremark, AllBenchmark, AMD e NVIDIA per le copie digitali dei benchmark utilizzati nelle nostre recensioni. Dove disponibile la scelta della risoluzione, i test sono stati eseguiti ai seguenti valori. Laddove si trattasse di un benchmark, le modalità predefinite sono state utilizzate:

- 1680×1050, AA x2

- 1920×1080, AA x4

- 2560×1440, no AA

Abbiamo recentemente aggiornato la configurazione di prova, e non avendo alcuna delle schede testate qui con noi, vi indichiamo qui di seguito le VGA testate con la nuova piattaforma:

- Sapphire AMD Radeon R9 290X Tri-X Vapor-X 4GB (Hawaii XT, 1080/1410)

- Sapphire AMD Radeon R9 290X Tri-X Vapor-X 4GB (CrossFireX) (Hawaii XT, 1080/1410, 2 GPU)

- Sapphire AMD Radeon R9 290X Tri-X Vapor-X 8GB (Hawaii XT, 1030/1375)

- Sapphire AMD Radeon R9 290X Tri-X Vapor-X 4GB (CrossFireX) (Hawaii XT, 1080/1410, 3 GPU)

- NVIDIA GeForce GTX980 (reference) (Maxwell GM204-400, 1127/1753)

Con il tempo, ripopoleremo i grafici con le VGA già recensite. Nel frattempo, potete consultare l’ultima recensione effettuata con la vecchia configurazione di sistema, comprensiva dei test delle VGA precedentemente recensite: Sapphire Radeon R9 285 Compact ITX.

Test sintetici: Unigine Heaven–>

Heaven, prodotto da Unigine è stato il primo Benchmark DX11. Lo scopo principale è quello di mettere in risalto gli straordinari effetti della Tessellation. Difatti dai semplici modelli osservabili con tessellation disattivata, si arriva ad oggetti ricchi di profondità e sporgenze senza dover creare trame complesse. Il compito di arricchire il modello è lasciato all’unità tessellatrice, per cui si tratta di uno strumento indispensabile per valutare l’efficienza dei questa unità nelle moderne soluzioni DX11:

Test sintetici: FutureMark 3DMark11–>3DMark11 è il penultimo nato di Futuremark. Finalmente, dopo una lunga attesa, è possibile testare le più recenti VGA in ambiente DX11 con la qualità del più rinomato benchmark. Il 3DMark11 consiste in quattro test grafici che fanno uso intensivo di Tessellation (particolare tecnologia introdotta con le DirectX11), un Physics Test esclusivamente dedicato alla CPU ed un Combined Test che mette sotto torchio allo stesso tempo il comparto grafico ed il processore:

Test sintetici: FutureMark 3DMark–>

In concomitanza con il lancio di Windows 8, Futuremark ha lanciato il nuovo 3DMark, chiamato appunto 3DMark, senza alcun numero riconoscitivo, a segnare la forte integrazione che ha con qualsiasi sistema, da Android a Windows a iOS a OSX, dando per la prima volta la possibilità di paragonare le prestazioni su smartphone e PC fisso in maniera schematizzata e professionale. Il benchmark dispone di svariati test, di cui utilizziamo i più intensivi per mettere alla prova le schede video. Tra questi, il più “blando” ma non per questo meno impegnativo è il Fire Strike, che spinge la tessellazione a livelli davvero elevati, e che “vanta” due versioni ancora più spinte: Extreme (con scene pre-renderizzate a 2560×1440) ed Ultra (scene pre-renderizzate a 3840×2160, ovvero 4K).

Test sintetici: 3DMark Fire Strike Extreme–>

Menzione a parte merita il benchmark Fire Strike Extreme, parte dell’ultima suite di test della Futuremark, il 3DMark (sì, quello senza numero), i cui requisiti sono davvero estremi e sconsigliati ai deboli di cuore. Tessellazione spinta all’inverosimile, effetti particellari in ogniddove, scintille, nuvole di fumo, fiamme, combattimenti, il tutto in FullHD, ma con un impatto davvero tremendo sulle prestazioni. Poche schede riescono a visualizzare in fluidità un macigno del genere:

Test sintetici: 3DMark Fire Strike Ultra–>

Come se non bastasse, recentemente Futuremark ha aggiornato la suite del suo ultimo benchmark con una versione spinta all’inverosimile del già affamato di risorse Fire Strike. Stiamo parlando del Fire Strike Ultra, benchmark ideato per testare sistemi multi-scheda di fascia altissima e le cui scene vengono pre-renderizzate in 4K. Sì, avete capito bene: Fire Strike Ultra è un benchmark così famelico di potenza che lanciarlo potrebbe fermare il tempo, attenzione:

Test sintetici: AllBenchmark CatZilla–> Definito da molti come l’Aquamark della next-gen, CatZilla nasce ad opera di una software house semi-sconosciuta (AllBenchmark, divisione software dell’azienda AllPlayer) intenta a portare una ventata di novità nel mondo del testing delle schede video. Il motore grafico proprietario mette in ginocchio tutte le ultime schede in commercio, grazie a gatti giganti (i CatZilla), esplosioni, effetti particellari e musica drum’n’bass che va di pari passo con le scene renderizzate. Il benchmark si avvale delle ultime tecnologie appartenenti alle librerie grafiche DirectX11 e OpenGL 4.2, con quattro diversi preset suddivisi in base alla risoluzione e alla qualità grafica. Noi eseguiremo i tre benchmark:

- 720p

- 1080p

- 1440p

Test sui giochi: Thief (2014)–>

Nato come reboot di Thief: The dark project, gioco che nel 1998 rivoluzionò le avventure grafiche introducendo luci ed ombre come elementi attivi del gameplay, Thief (2014) è un gioco sviluppato da Eidos Montreal e Square Enix, aziende che l’anno scorso hanno lavorato già ad un altro reboot, anch’esso utilizzato nella nostra suite di test: Tomb Raider. La storia ci catapulta nei panni di Garrett, un abilissimo e ricercatissimo ladro, alle prese con una nuova “setta” che si avvale di poteri magici di potenza incommensurabili, e nel frattempo cercando di salvare una donna molto importante: sua figlia. Tralasciando il filone logico del gioco, esso si avvale dal punto di vista tecnico di un motore grafico che supporta le DirectX11.1, con il feature level di tipo 11_2, avvalendosi del supporto a Mantle, SSAO, Contact Hardening Shadows e Diffusion DOF. Al pari di Bioshock Infinite, viene anche fornito il supporto all’FXAA, antialiasing ad approssimazione rapida, ottimizzato su Shader Model di 5° generazione. Il gioco è ottimizzato per architetture AMD, in quanto parte del programma AMD Gaming Evolved.

Test sui giochi: Bioshock Infinite–>Continuiamo con Bioshock Infinite, che ci mette nei panni di Booker DeWitt, un investigatore privato, un tempo agente Pinkerton, incaricato di ritrovare una ragazza, Elizabeth, tenuta prigioniera a Columbia, una fantomatica città sospesa nei cieli, dove le modifiche genetiche sono considerate veri e propri beni di lusso. Per la prima volta nella serie di Bioshock, il personaggio ha un volto, un nome ed una storia precedente al gioco, che verrà svelata con l’avanzare della partita. Il gioco supporta le API DirectX 11, con le quali supporta tecnologie quali: High Definition Ambient Occlusion, Contact Hardening Shadows e Diffusion Depth of Field. È implementato inoltre il supporto all’FXAA (anti-aliasing ad approssimazione rapida) ottimizzato per l’utilizzo su SM 5.0. Il gioco è ottimizzato per architetture AMD, in quanto parte del programma AMD Gaming Evolved.

Test sui giochi: Metro Last Light–>

Dopo l’incredibile successo di Metro 2033, ecco che fa capolino sugli schermi dei nostri PC il suo successore, Metro Last Light, basato sul romanzo Metro 2034 di Dmitry Glukhovsky, che vede il mondo alle prese con i postumi di una terza guerra mondiale atomica, con tutto ciò che ne consegue: la popolazione ancora in vita in Russia si è trasferita nella famigerata metropolitana russa, dotata di 298 km di binari e tunnel sotto Mosca. Ancora una volta, il giocatore rivestirà i panni di Artyom, per impedire una guerra civile che potrebbe portare alla fine il genere umano. Tecnicamente parlando, il gioco è incredibilmente pesante, sia per poligoni a schermo che per requisiti, facendo uso di tutte le tecnologie introdotte dalle DirectX11: Depth of Field, HDAO, Tessellation e real-time Motion Blur. Il gioco è ottimizzato per schede video NVIDIA, dato il supporto all’NVIDIA PhysX e in quanto parte del programma NVIDIA – The Way It’s Meant To Be Played.

Test sui giochi: Tomb Raider (2013)–>

Chi è appassionato della saga di J.R.R. Tolkien sa che, fino a Settembre 2014, non esisteva un gioco degno di tal nome che narrasse le vicende della Terra di mezzo. Grazie a Monolith e ai Warner Studios, però, ora la collana fantasy più famosa del globo terracqueo vanta un gioco tripla A, forte di una trama travolgente, una grafica sul filo del fotorealismo ed un sistema di combattimento che sembra l’evoluzione del Free Form Fighting System visto in Prince of Persia: Spirito Guerriero. Il risultato? Un titolo must-have, il cui motore grafico si rifa a quello utilizzato da Batman: Arkham Origins, titolo che sostituisce nella nostra suite di benchmarks. Il gioco è ottimizzato per schede video NVIDIA, dato il supporto all’HBAO, all’SMAA e più in generale a tutti i GameWorks dell’azienda. Il gioco, soprattutto alle alte risoluzioni e con i filtri al massimo, richiede un quantitativo di memoria video non indifferente, e pertanto risulta pienamente indicato qualora voleste mettere alla prova schede video con un quantitativo VRAM maggiore:

Considerazioni finali–> [conclusione]

[titolo]Design e qualità costruttiva[/titolo]

Permane il design perfetto della scheda di Sapphire, con un PCB ed una sezione di alimentazione corazzati, un design unico del dissipatore (che si avvale della tecnologia Vapor-Chamber per temperature bassissime) e frequenze superiori al modello reference. La scheda è solidissima e la backplate aiuta a raffreddare il PCB nella sua interezza, conferendo comunque la solidità necessaria affinché esso non si pieghi sotto il peso del voluminoso sistema di raffreddamento. Utile la retroilluminazione LED che varia a seconda della temperatura della GPU: blu se inferiore ai 60°C, gialla tra i 60 e i 70°C, rossa se superiore ai 70°C. In single GPU, non abbiamo mai visto la scheda arrivare al colore rosso con la ventola in Auto.

[voto=”10″]

[/conclusione]

[conclusione]

[titolo]Prestazioni e overclock[/titolo]

La Sapphire Radeon R9 290X Vapor-X da 8GB è una scheda dai “mixed feelings”: se da un lato, ritroviamo la potenza della “classica” 290X, dall’altro ci troviamo di fronte ad un buffer di memoria maggiorato, che si prospetta come un vero e proprio gamechanger rispetto alla stessa GPU con “soli” 4GB di vRAM e rispetto alla concorrenza, che finora ha presentato modelli da 4 GB (GTX980, 970) e 6 GB (Titan, Titan Black), arrivando a “soli” 3 GB nel caso delle proposte inferiori (GTX780, 780Ti). Come è visibile nei grafici dei test da noi effettuati, la differenza di prestazioni ottenuta col modello da 4 GB è soltanto il frutto dei 50 MHz di overclock che quest’ultima ha di vantaggio rispetto al modello oggi recensito. Quindi la R9 290X da 8GB, come è logico aspettarsi, è veloce almeno quanto il modello da 4 GB. Direte voi, allora: quand’è che servono gli 8 GB? La risposta è semplice: in 4K. Non disponiamo (ancora per poco) di un monitor con risoluzione 4K, pertanto non possiamo dimostrare coi fatti tale situazione, ma appena sarà possibile, sempre in collaborazione con Sapphire, vi dimostreremo che la R9 290X da 8GB è un acquisto più che sensato se giocate ad altissime risoluzioni e con i filtri (SuperSampling AntiAliasing in primis) al massimo.

[voto=”8″]

[/conclusione]

[conclusione]

[titolo]Compatibilità e consumi[/titolo]

Sul fattore compatibilità, la scheda dispone di connessione PCI-E 16x di tipo 3.0, retrocompatibile con lo standard 2.0 (non è assicurata la compatibilità su schede madri con connessione PCI-E 16x di prima generazione), mentre da lato alimentatore è suggerito dall’azienda un alimentatore da almeno 600W. Noi di ReHWolution, però, possiamo garantirvi che basta un buon alimentatore da 500W per assicurarvi la piena stabilità operativa. Qualora voleste configurare un sistema a due GPU, l’alimentatore consigliato è di 1000W, in modo da avere un ottimo margine di overclock. Se volete osare e usare 3 o 4 schede video, fareste bene a pensare di comprare un alimentatore da 1600W, soprattutto se queste bestioline non volete tenerle a default.

[voto=”9″]

[/conclusione]

[conclusione]

[titolo]Prezzo[/titolo]

La scheda è disponibile ad un prezzo di circa 475€, presentando un sovrapprezzo di 75€ rispetto al modello da 4GB che presenta un rapporto qualità/prezzo di gran lunga superiore. Ricordiamo, però, che una scheda del genere è indirizzata a chi ha un monitor ad alta risoluzione (1440p+) e pertanto a chi non bada a spese quando si tratta di avere l’hardware più veloce. È anche vero che la GTX980, diretta concorrente, presenta un prezzo leggermente superiore insieme a consumi più contenuti e prestazioni decisamente maggiori. Vi invitiamo ad acquistare presso i rivenditori ufficiali Sapphire, in quanto pur presentando un prezzo superiore ai VAT Player (coloro che evadono l’iva tramite meccanismi al limite della legalità), forniscono supporto post-vendita/RMA, cosa che suddetti rivenditori non ufficiali non garantiscono.

[voto=”8″]

[/conclusione]

Insomma, la R9 290X Vapor-X 8GB oggi recensita è un mix di emozioni, ma vista la potenza di cui dispone e la predisposizione al futuro (parlando onestamente, sono pochissimi i giochi che riescono a sfruttare tutti gli 8GB di memoria video), diamo alla scheda video oggi analizzata il nostro Hardware Gold Award:

Ringraziamo Sapphire Italia per il sample oggi recensito.

Seguiteci sui nostri social network:

La recensione

Sapphire AMD Radeon R9 290X Tri-X Vapor-X 8GB

Versione "maggiorata" nella RAM video, la R9 290X Vapor-X di Sapphire da 8GB è la scheda perfetta se puntate alle risoluzioni superiori al 2K, o se semplicemente volete pompare al massimo la qualità dei filtri a risoluzioni elevate.

Pro

- Scheda video gelida

- Prestazioni al massimo di categoria

- Silenziosissima

- Design spettacolare

Contro

- Prezzo leggermente alto

- 8GB non sono per tutti: 4K e giochi di ultima generazione sono i soli a giustificare l'acquisto

Discussione su post