Introduzione: Sapphire Technology–>

Ci siamo! Dopo 2 anni di attesa AMD ha rilasciato una serie di “nuove” GPU, e oggi Sapphire ci da modo di recensire il modello di punta di una delle due lineup annunciate all’E3 2015. Non parliamo delle Fury, basate su GPU Fiji, che vedranno il lancio a fine mese, ma della serie Rx 300.

Come vedrete, la serie Rx 300 è un refresh della precedente serie Rx 200, e oggi sul banco di prova abbiamo la R9 390X Tri-X, con ben 8GB di GDDR5.

Sapphire Radeon R9 390X Tri-X 8GB: specifiche tecniche–>

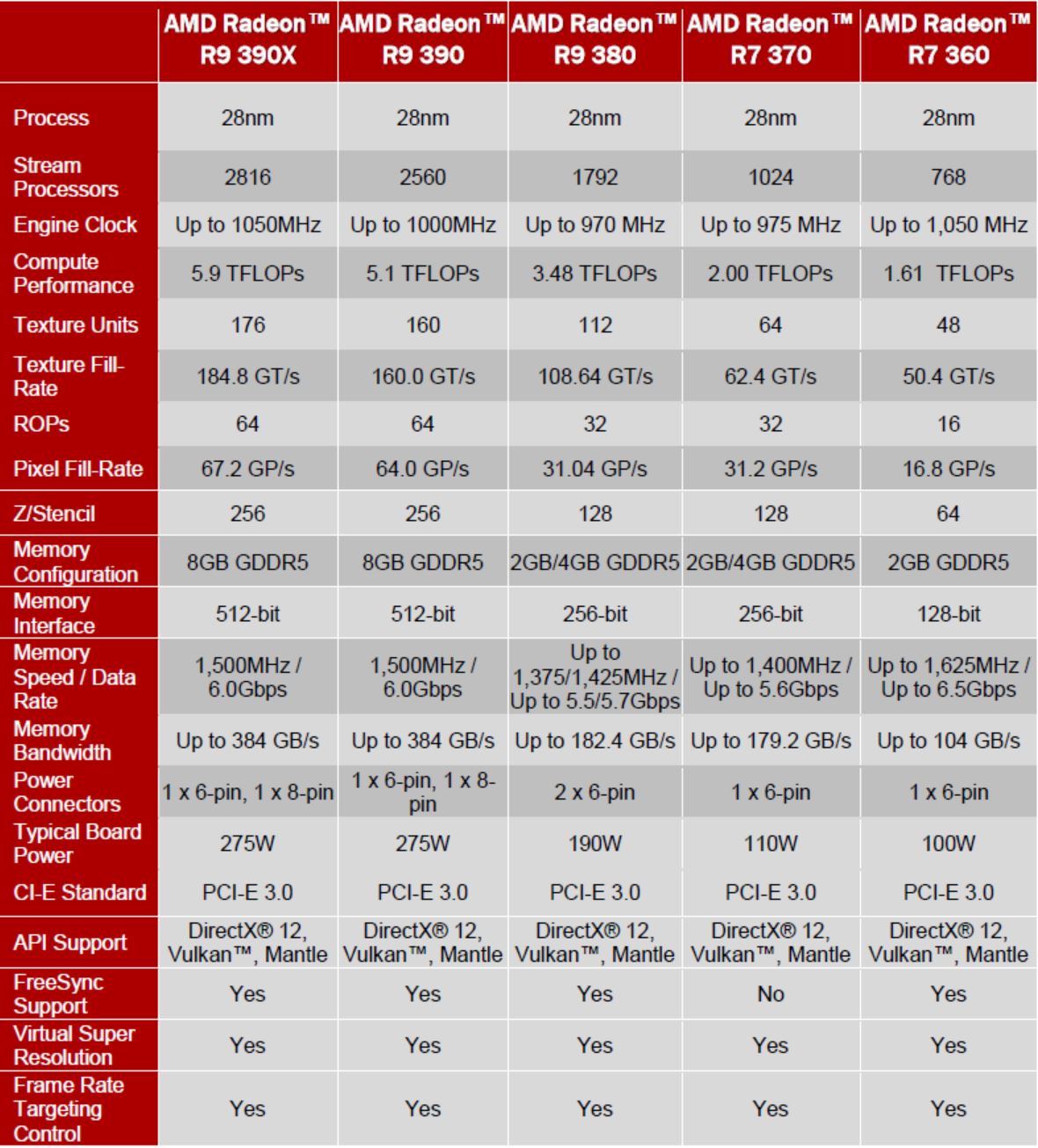

Di seguito, una tabella che riassume le specifiche di tutta la lineup AMD per la serie Rx 300:

Senza soffermarci sulle specifiche delle altre schede, focalizziamoci sulla 390X: con 2816 Stream Processors ed una frequenza di 1050 MHz, la GPU alla base di questa scheda grafica è denominata Grenada XT, che sembra essere un refresh di Hawaii XT, equipaggiata dalle 290X. Le memorie, rispetto a quest’ultima, vedono un incremento di circa 1 GHz, passando da 1250 MHz effettivi a 1500 MHz effettivi.

L’alimentazione è affidata a due connettori, uno a 6 pin ed uno a 8 pin, con un Typical Board Power (assorbimento tipico) di 275W al massimo. Sono garantiti, per questa GPU, il supporto alle tecnologie FreeSync, VSR (Virtual Super Resolution) e FRTC (Frame Rate Targeting Control), senza dimenticare il supporto alle DirectX 12, Vulkan e Mantle. Di tutto queste features parleremo approfonditamente nelle prossime pagine.

Sapphire R9 390X Tri-X

Nello specifico, la versione da noi recensita dispone di una frequenza GPU di 1055 MHz e di una frequenza VRAM di 6100 MHz (1525 MHz QDR), mentre l’alimentazione è affidata ad un doppio connettore PEG 8 Pin, consentendo di spingere ulteriormente le frequenze operative e di garantire maggiore stabilità anche in overclock. Il sistema di dissipazione, così come il PCB, è personalizzato secondo la formula Tri-X di Sapphire, che con questa serie di GPU vede una reincarnazione più sobria, con uno shroud in plastica totalmente nero e accent dorati. Inoltre, le ventole si disattivano con carichi di entità minore, garantendo rumorosità pari a 0 dB(A).

Un design decisamente più elegante e che meglio si sposa con sistemi attuali.

Galleria fotografica: Sapphire Radeon R9 390X Tri-X 8GB–>

Di seguito, una galleria di foto della scheda video e del bundle:

L’architettura nei dettagli: AMD PowerTune–>

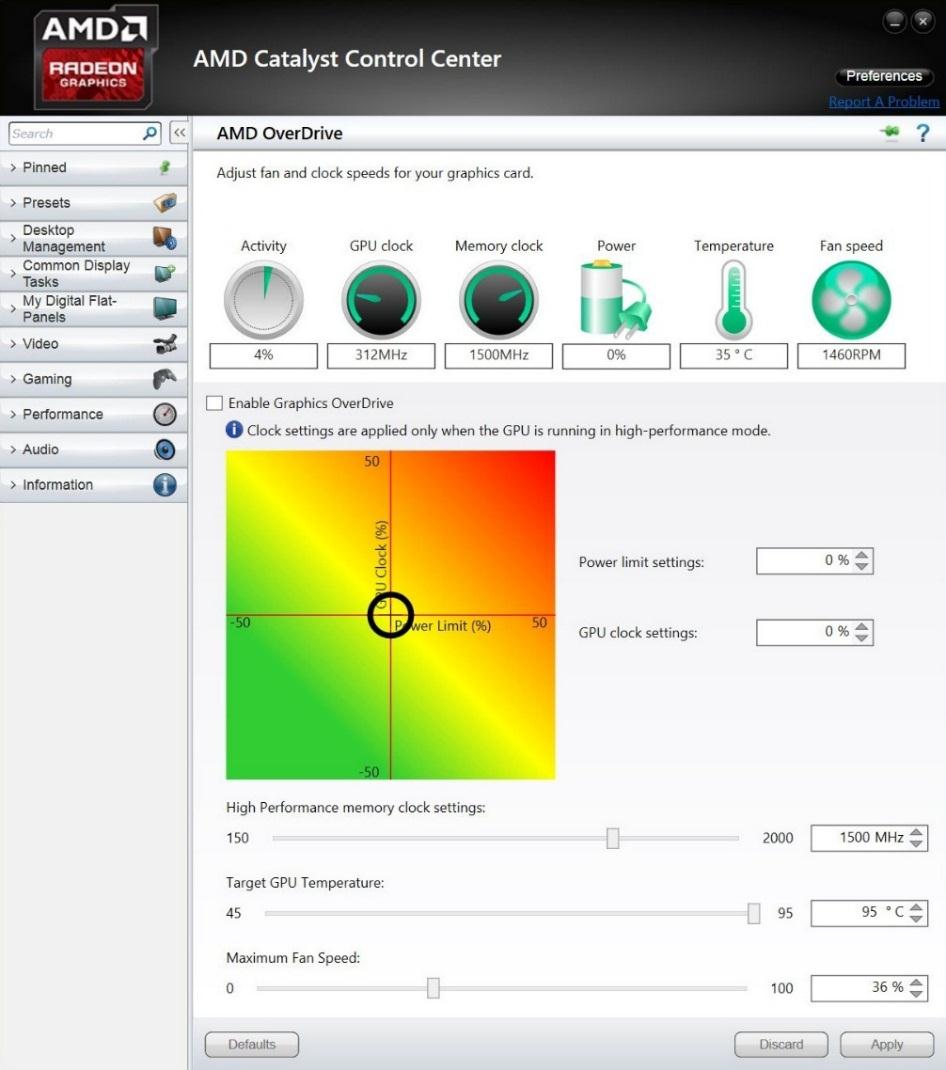

La tecnologia PowerTune è una feature esclusiva che ottimizza le prestazioni della GPU seguendo una serie di condizioni modificando dinamicamente frequenze, voltaggi e velocità delle ventole, fornendo le migliori performance possibili per un dato limite termico o di potenza assorbita. La nuova schermata AMD Overdrive nell’interfaccia utente del Catalyst Control Center offre ancora più flessibilità per gestire il comportamento della GPU. L’overclock non è più inteso nei termini di un valore assoluto di frequenza (ad esempio 1000 MHz). Invece, l’utente ha controllo su più parametri per aumentare le performance. AMD OverDrive include un controllo per le frequenze GPU che aumenta i clock medi di una certa percentuale, mantenendo al contempo i parametri stabiliti per potenza, temperature e velocità ventola.

L’architettura nei dettagli: Frame Rate Targeting Control–>

Seguendo il discorso dell’assorbimento di corrente e dell’efficienza, il Frame Rate Targeting Control è una nuova feature che viene introdotta con la serie 300 di schede grafiche AMD, permettendo agli utenti di impostare il massimo framerate di una determinata applicazione in full screen; i benefici che l’FRTC sono i ridotti consumi per la GPU (ottimo quando i giochi vanno a più FPS della frequenza di aggiornamento dello schermo) e la riduzione del calore e del rumore generati dalla scheda. Di seguito uno screenshot della feature nel Catalyst Control Center:

L’architettura nei dettagli: Virtual Super Resolution–>

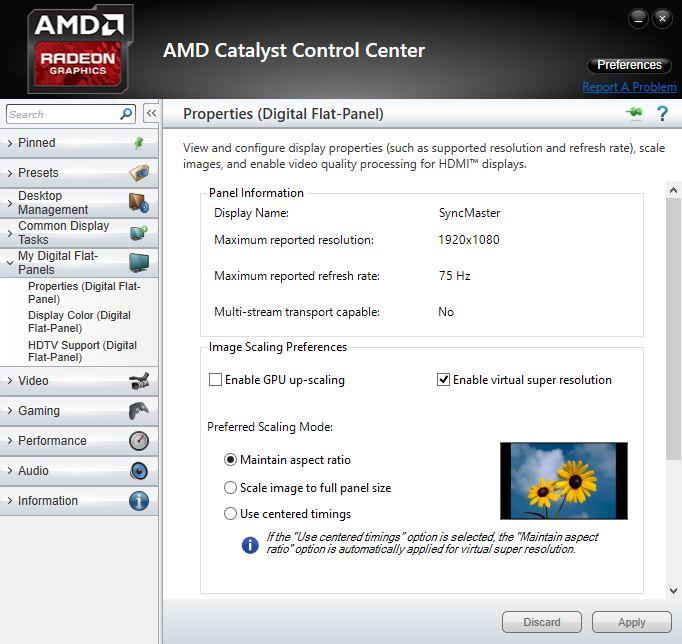

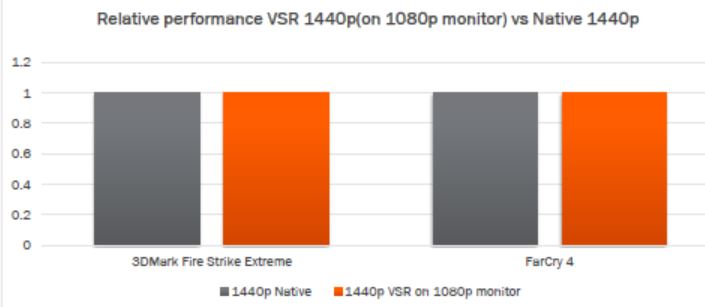

Il Super Sampling Anti-Aliasing (SSAA) è uno dei metodi di anti-aliasing che creano texture più uniformi e meno problemi poligonali, ma non è supportato da tutti i giochi o motori grafici. La VSR è una feature agnostica nei confronti di giochi e motori grafici, ed è una feature che consente di simulare l’SSAA in qualsiasi gioco. La VSR può essere utilizzata in congiunzione con l’AA nativo, per una granularità ancora maggiore nei settaggi grafici. La VSR permette di renderizzare ad una risoluzione maggiore (fino a 4K) e downscalare alla risoluzione nativa dello schermo. Utilizzandola, si può avere la qualità di uno schermo 4K su un monitor 1080p:

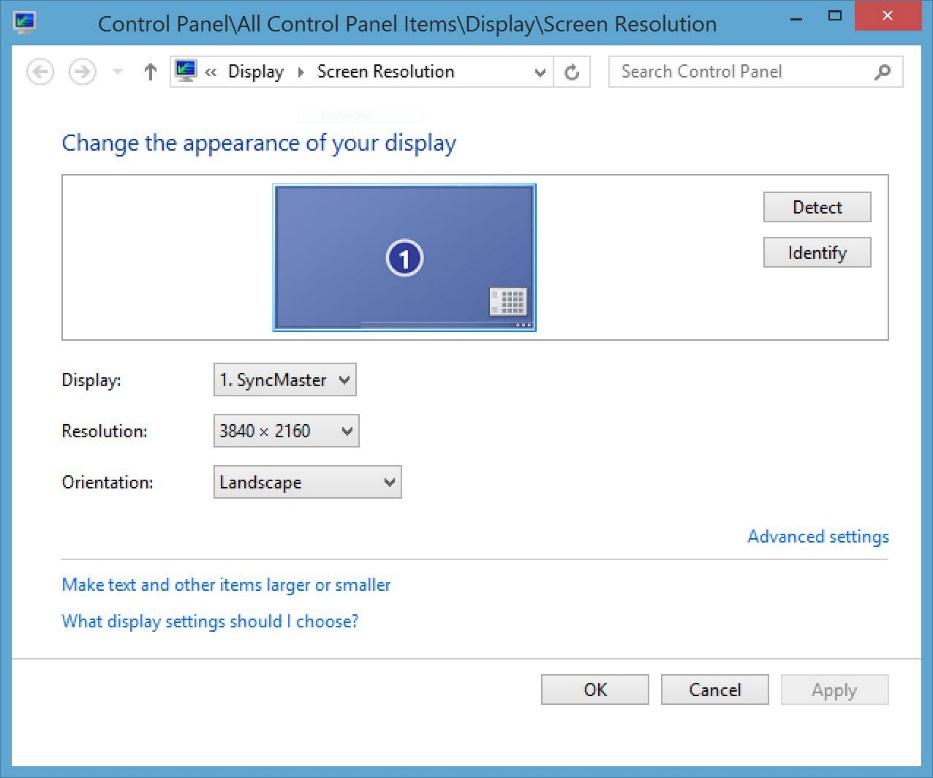

Una volta abilitata la feature, si può aumentare la risoluzione sia ingame che sul desktop. Qui, lo screenshot delle impostazioni di Windows su di uno schermo Full HD ma con VSR attivata:

Una delle caratteristiche più interessanti di questa tecnologia è che l’impatto prestazionale è pari al carico di lavoro generato da un’immagine generata su di uno schermo 4K. Nulla è perduto sul fronte dello scaling delle immagini, ottenendo lo stesso numero di FPS che si otterrebbero in 4K con un livello qualitativo quasi pari:

L’architettura nei dettagli: DX12–>

Le DirectX 12 sono nuove API grafiche di Microsoft simili a quelle utilizzate dalla console, che permette agli sviluppatori di giochi un maggiore e miglior accesso alle risorse hardware. Questo controllo diretto o “esplicito” migliora la resa prestazionale delle CPU AMD FX, delle APU e delle AMD Radeon. In soldoni: hardware più efficiente grazie a software più intelligente. A discrezione dello sviluppatore di giochi, questa efficienza superiore può essere utilizzata per un maggior framerate, per minore latenza (contesto ideale per la VR), minori consumi, miglior qualità dell’immagine o una combinazione bilanciata di queste 4 direzioni. In ogni scenario, i videogiocatori beneficieranno della scelta di hardware AMD per giocare a titoli compilati in DX12. La serie AMD Radeon 300 supporta pienamente le DirectX 12, con miglioramenti rispetto ai prodotti precedenti grazie a:

- Tassellazione più veloce

- Tiled Resources (il supporto a enormi texture virtuali, abilitando il caricamento dinamico di porzioni di esse nella VRAM per dettagli sempre al massimo della qualità)

Shaders asincroni

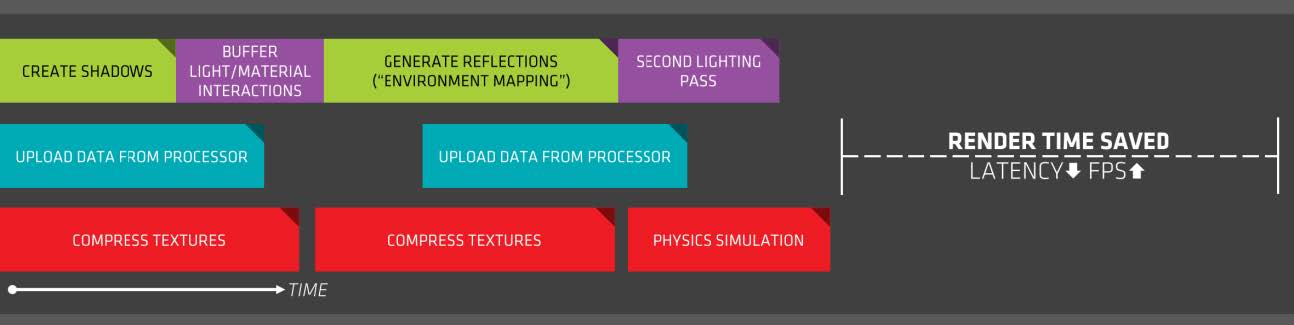

Gli shaders asincroni sono una nuova feature delle DX12 che permettono a complicate operazioni di calcolo grafico di utilizzare tutte le risorse disponibili sulle GPU AMD Radeon. Spezzare un calcolo più grande in più parti piccole e processarle parallelamente aumenta enormemente l’efficienza e le prestazioni; AMD, con la sua architettura Graphics Core Next, ha una porzione hardware dedicata a tale compito, l’Asynchronous Compute Engine, capace di svolgere tale operazione ad una velocità davvero elevata.

Ecco una semplice illustrazione di come questo processo avveniva prima di questa tecnologia:

Con l’utilizzo degli ASYNC Shaders invece:

Il risultato consiste in un più veloce processing di ogni frame, ottimizzando i tempi e aumentando il framerate sensibilmente.

Multi-GPU con le DX12

Le versioni precedenti delle DirectX non supportavano direttamente le configurazioni multi-GPU. Gli sviluppatori hanno progettato il loro supporto personalizzato nei giochi e nei drivers, ma spesso con limitazioni: minimo controllo sull’hardware, combinazioni di GPU ristrette e difficoltà nell’ottimizzare il carico di lavoro su più GPU. Il multiadapter esplicito delle DirectX 12 aggiunge il supporto al multi-GPU per la prima volta, permettendo agli sviluppatori di giochi un livello di controllo diretto dell’hardware PC. In questo modo, i motori grafici potranno tirar fuori prestazioni maggiori dai sistemi multi-GPU, utilizzando configurazioni semplicemente irrealizzabili in DirectX 11, come ad esempio la coesistenza di GPU di brand diversi.

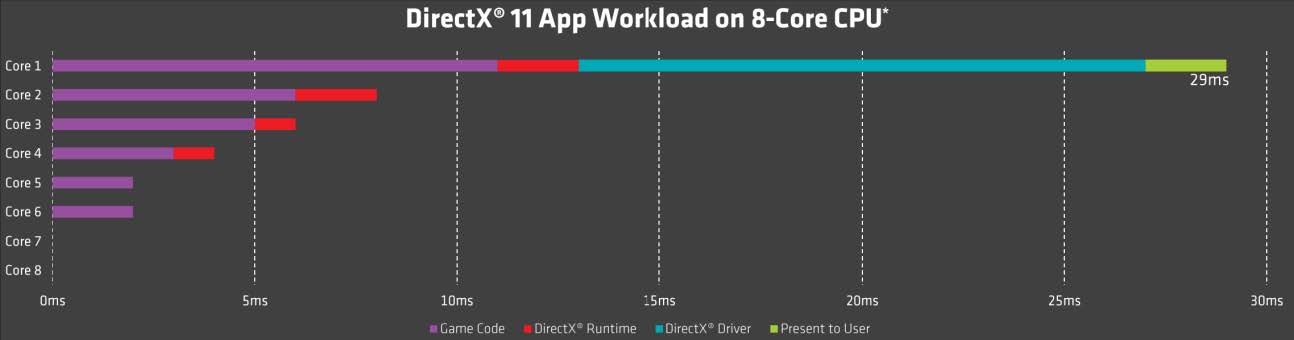

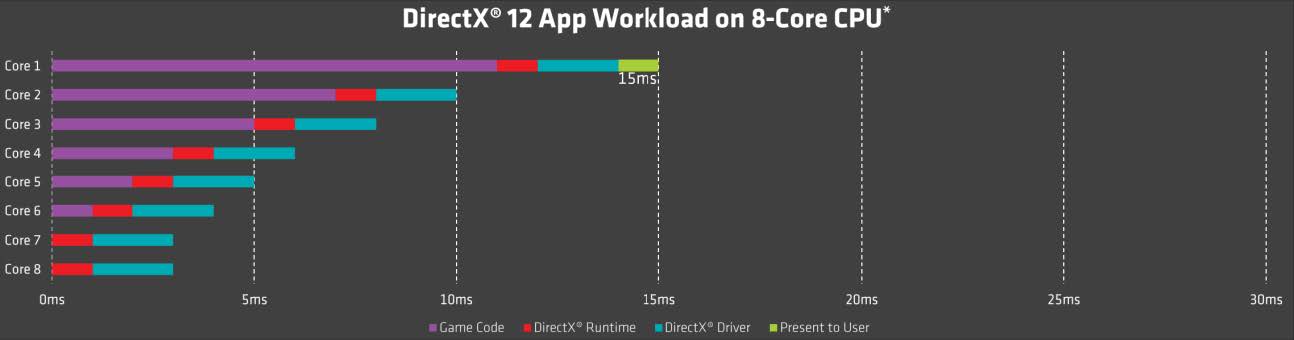

Efficienza con CPU multi-core

Le versioni precedenti delle DirectX non erano capaci di utilizzare appieno una CPU multi-core come i processori AMD FX a 8 core. Gran parte del lavoro delle API grafiche in un PC finiscono per sovraccaricare uno o due core della CPU, peggiorando le performance drasticamente. Con le DirectX 12, invece, il carico di lavoro di un motore grafico può essere suddiviso su tutti e 8 i core, portando ad un’uniformità nel tempo di esecuzione di una serie di calcoli.

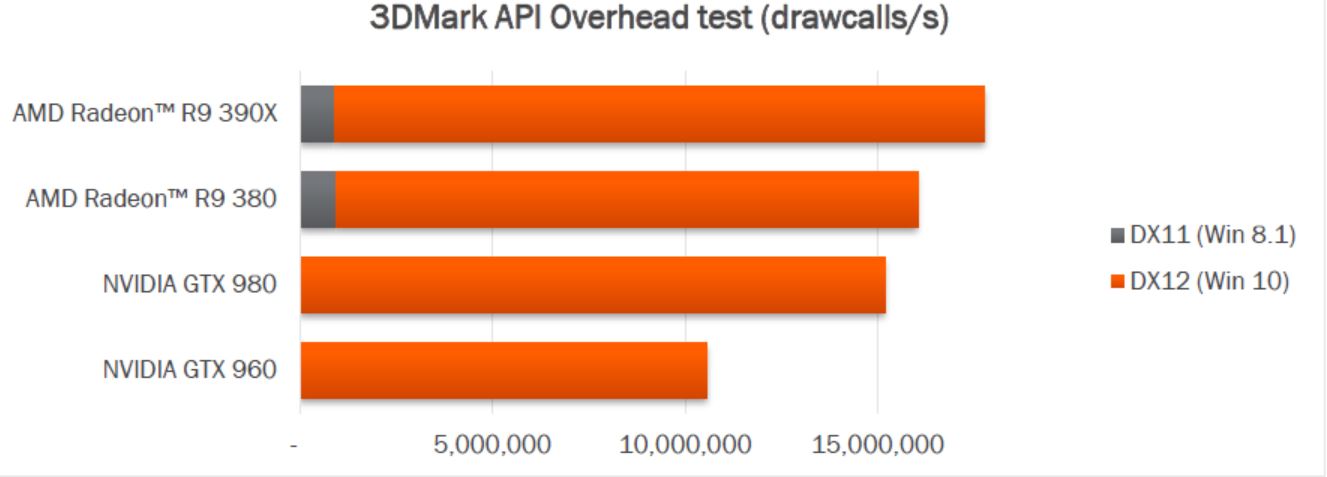

3DMark® API Overhead feature test

Il test Overhead API del 3DMark’s API è utilizzato per misurare l’efficienza di un API su una determinata scheda grafica. Con le DirectX 12 (su Windows 10) AMD ha visto un drastico incremento nel numero di chiamate draw al secondo paragonato ai competitors e ai risultati in DirectX 11 (su Windows 8.1):

L’architettura nei dettagli: FreeSync–>

La tecnologia AMD FreeSync sincronizza, su determinate APU e GPU AMD, il refresh rate di un monitor con l’output della scheda grafica, eliminando il fastidioso fenomeno del tearing e dello stuttering-

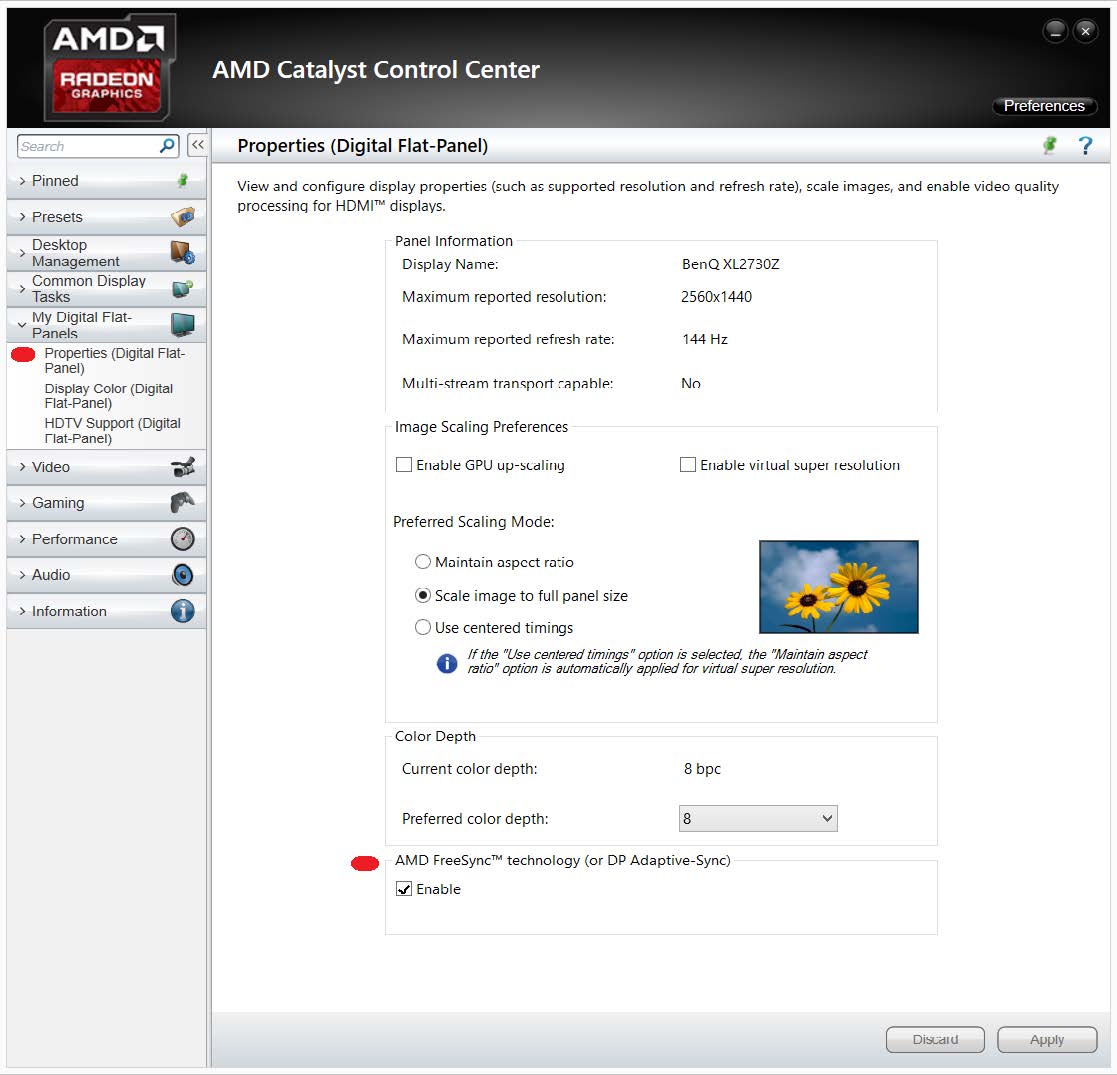

Per abilitare l’AMD FreeSync, basta connettersi ad un monitor compatibile con la tecnologia AMD FreeSync, abilitandola poi nel pannello Catalyst Control Center.

Inoltre, non c’è paragone con la soluzione adottata da NVIDIA, il G-Sync:

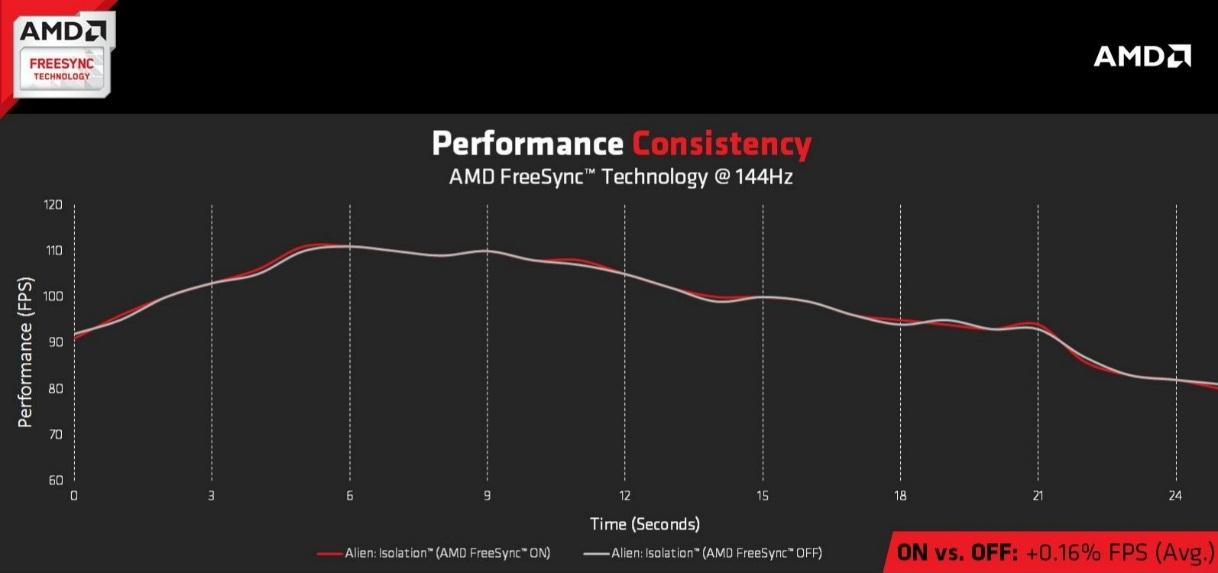

Un’altra questione importante sul FreeSync è che è free. Non c’è impatto prestazionale utilizzandolo, e gli FPS dei giochi rimane lo stesso di prima. Qui è mostrata una run di Alien Isolation con e senza FreeSync:

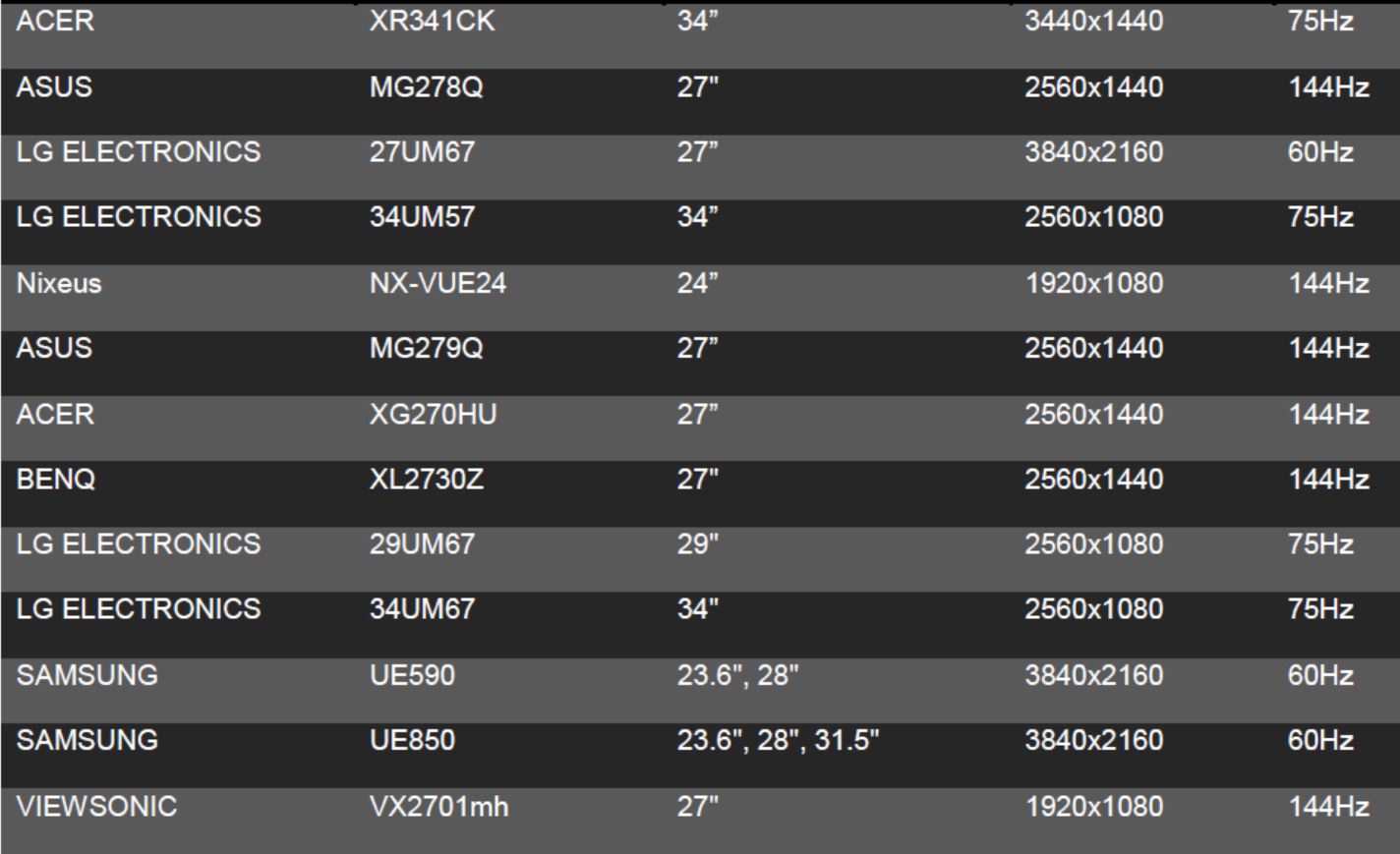

Ecco una lista dei monitor attualmente compatibili con la tecnologia FreeSync:

AMD FreeSync è una tecnologia free: libera da costi aggiuntivi per hardware, libera da penalità prestazionali, libera come standard, aperta a chiunque voglia utilizzarla nel mondo del gaming, con un feeling che difficilmente vi farà tornare indietro.

Configurazione di prova e metodologia di test–>

La configurazione utilizzata per i test è la seguente:

| CPU | Intel Core i7 5960x |

|---|---|

| Heatsink | Swiftech H240-X AIO Liquid Cooling |

| Mainboard | ASUS ROG Rampage V Extreme |

| RAM | Corsair Dominator Platinum DDR4 16 GB 2666 MHz |

| VGA | Sapphire Radeon R9 390X Tri-X |

| Sound Card | Creative SoundBlaster Omni 5.1 e Creative T30 Wireless Speakers |

| HDD/SSD |

|

| PSU | Corsair AX1500i Digital PSU |

| Case | Corsair Graphite 780T Arctic White |

| Monitor | Acer CB280HK 4K Display |

| Keyboard | Corsair Gaming K70 RGB |

| Mouse | Corsair Gaming Sabre RGB Laser |

| OS | Windows 8.1 Pro x64 |

Ecco la suite di benchmark (e giochi) con cui testeremo la scheda video:

- Unigine Heaven Benchmark 4.0

- Futuremark 3DMark Fire Strike

- Futuremark 3DMark Fire Strike Extreme

- Futuremark 3DMark Fire Strike Ultra

- Thief (2014) (Benchmark integrato)

- Bioshock Infinite (Benchmark integrato)

- Metro Last Light (Benchmark integrato)

- Terra di mezzo: Ombra di Mordor (Benchmark integrato)

Dove disponibile la scelta della risoluzione, i test sono stati eseguiti ai seguenti valori. Laddove si trattasse di un benchmark, le modalità predefinite sono state utilizzate:

- 1680×1050, AA x2 (WSXGA+)

- 1920×1080, AA x4 (Full HD)

- 2560×1440, no AA (2K, QWHD)

- 3840×2160, no AA (4K, UHD)

Qui di seguito le VGA testate con la nuova piattaforma:

- Sapphire AMD Radeon R7 250X Vapor-X OC 1GB (Cape Verde XT, 1100/1300) – Recensione

- Sapphire AMD Radeon R9 290X Tri-X OC 8GB (Hawaii XT, 1020/1375) – Recensione

- Sapphire AMD Radeon R9 290X Tri-X Vapor-X 4GB (Hawaii XT, 1080/1410) – Recensione

- Sapphire AMD Radeon R9 290X Tri-X Vapor-X 8GB (Hawaii XT, 1030/1375) – Recensione

- Sapphire AMD Radeon R9 290X Tri-X Vapor-X 4GB (CrossFireX) (Hawaii XT, 1080/1410, 2 GPU) – Recensione

- Sapphire AMD Radeon R9 290X Tri-X Vapor-X 4GB (CrossFireX) (Hawaii XT, 1080/1410, 3 GPU) – Recensione

- Sapphire AMD Radeon R9 390X Tri-X 8GB (Grenada XT, 1055/1525) – Recensione

- MSI NVIDIA GeForce GTX960 Twin Frozr V Gaming 2GB (Maxwell GM-206-300, 1241/1753) – Recensione

- MSI NVIDIA GeForce GTX970 Twin Frozr V Gaming 4GB (Maxwell GM-204-200, 1140/1753) – Recensione

- ASUS NVIDIA GeForce GTX980 Strix OC 4GB (Maxwell GM-204-400, 1178/1753) – Recensione

- NVIDIA GeForce GTX980 4GB (reference) (Maxwell GM204-400, 1127/1753) – Recensione

Test sintetici: Unigine Heaven–>

Heaven, prodotto da Unigine è stato il primo Benchmark DX11. Lo scopo principale è quello di mettere in risalto gli straordinari effetti della Tessellation. Difatti dai semplici modelli osservabili con tessellation disattivata, si arriva ad oggetti ricchi di profondità e sporgenze senza dover creare trame complesse. Il compito di arricchire il modello è lasciato all’unità tessellatrice, per cui si tratta di uno strumento indispensabile per valutare l’efficienza dei questa unità nelle moderne soluzioni DX11:

Test sintetici: FutureMark 3DMark–>

In concomitanza con il lancio di Windows 8, Futuremark ha lanciato il nuovo 3DMark, chiamato appunto 3DMark, senza alcun numero riconoscitivo, a segnare la forte integrazione che ha con qualsiasi sistema, da Android a Windows a iOS a OSX, dando per la prima volta la possibilità di paragonare le prestazioni su smartphone e PC fisso in maniera schematizzata e professionale. Il benchmark dispone di svariati test, di cui utilizziamo i più intensivi per mettere alla prova le schede video. Tra questi, il più “blando” ma non per questo meno impegnativo è il Fire Strike, che spinge la tessellazione a livelli davvero elevati, e che “vanta” due versioni ancora più spinte: Extreme (con scene pre-renderizzate a 2560×1440) ed Ultra (scene pre-renderizzate a 3840×2160, ovvero 4K).

Test sintetici: 3DMark Fire Strike Extreme–>

Menzione a parte merita il benchmark Fire Strike Extreme, parte dell’ultima suite di test della Futuremark, il 3DMark (sì, quello senza numero), i cui requisiti sono davvero estremi e sconsigliati ai deboli di cuore. Tessellazione spinta all’inverosimile, effetti particellari in ogniddove, scintille, nuvole di fumo, fiamme, combattimenti, il tutto in FullHD, ma con un impatto davvero tremendo sulle prestazioni. Poche schede riescono a visualizzare in fluidità un macigno del genere:

Test sintetici: 3DMark Fire Strike Ultra–>

Come se non bastasse, recentemente Futuremark ha aggiornato la suite del suo ultimo benchmark con una versione spinta all’inverosimile del già affamato di risorse Fire Strike. Stiamo parlando del Fire Strike Ultra, benchmark ideato per testare sistemi multi-scheda di fascia altissima e le cui scene vengono pre-renderizzate in 4K. Sì, avete capito bene: Fire Strike Ultra è un benchmark così famelico di potenza che lanciarlo potrebbe fermare il tempo, attenzione:

Test sui giochi: Thief (2014)–>

Nato come reboot di Thief: The dark project, gioco che nel 1998 rivoluzionò le avventure grafiche introducendo luci ed ombre come elementi attivi del gameplay, Thief (2014) è un gioco sviluppato da Eidos Montreal e Square Enix, aziende che l’anno scorso hanno lavorato già ad un altro reboot, anch’esso utilizzato nella nostra suite di test: Tomb Raider. La storia ci catapulta nei panni di Garrett, un abilissimo e ricercatissimo ladro, alle prese con una nuova “setta” che si avvale di poteri magici di potenza incommensurabili, e nel frattempo cercando di salvare una donna molto importante: sua figlia. Tralasciando il filone logico del gioco, esso si avvale dal punto di vista tecnico di un motore grafico che supporta le DirectX11.1, con il feature level di tipo 11_2, avvalendosi del supporto a Mantle, SSAO, Contact Hardening Shadows e Diffusion DOF. Al pari di Bioshock Infinite, viene anche fornito il supporto all’FXAA, antialiasing ad approssimazione rapida, ottimizzato su Shader Model di 5° generazione. Il gioco è ottimizzato per architetture AMD, in quanto parte del programma AMD Gaming Evolved.

Test sui giochi: Bioshock Infinite–>

Continuiamo con Bioshock Infinite, che ci mette nei panni di Booker DeWitt, un investigatore privato, un tempo agente Pinkerton, incaricato di ritrovare una ragazza, Elizabeth, tenuta prigioniera a Columbia, una fantomatica città sospesa nei cieli, dove le modifiche genetiche sono considerate veri e propri beni di lusso. Per la prima volta nella serie di Bioshock, il personaggio ha un volto, un nome ed una storia precedente al gioco, che verrà svelata con l’avanzare della partita. Il gioco supporta le API DirectX 11, con le quali supporta tecnologie quali: High Definition Ambient Occlusion, Contact Hardening Shadows e Diffusion Depth of Field. È implementato inoltre il supporto all’FXAA (anti-aliasing ad approssimazione rapida) ottimizzato per l’utilizzo su SM 5.0. Il gioco è ottimizzato per architetture AMD, in quanto parte del programma AMD Gaming Evolved.

Test sui giochi: Metro Last Light–>

Dopo l’incredibile successo di Metro 2033, ecco che fa capolino sugli schermi dei nostri PC il suo successore, Metro Last Light, basato sul romanzo Metro 2034 di Dmitry Glukhovsky, che vede il mondo alle prese con i postumi di una terza guerra mondiale atomica, con tutto ciò che ne consegue: la popolazione ancora in vita in Russia si è trasferita nella famigerata metropolitana russa, dotata di 298 km di binari e tunnel sotto Mosca. Ancora una volta, il giocatore rivestirà i panni di Artyom, per impedire una guerra civile che potrebbe portare alla fine il genere umano. Tecnicamente parlando, il gioco è incredibilmente pesante, sia per poligoni a schermo che per requisiti, facendo uso di tutte le tecnologie introdotte dalle DirectX11: Depth of Field, HDAO, Tessellation e real-time Motion Blur. Il gioco è ottimizzato per schede video NVIDIA, dato il supporto all’NVIDIA PhysX e in quanto parte del programma NVIDIA – The Way It’s Meant To Be Played.

Test sui giochi: Middle Earth: Shadow of Mordor–>

Chi è appassionato della saga di J.R.R. Tolkien sa che, fino a Settembre 2014, non esisteva un gioco degno di tal nome che narrasse le vicende della Terra di mezzo. Grazie a Monolith e ai Warner Studios, però, ora la collana fantasy più famosa del globo terracqueo vanta un gioco tripla A, forte di una trama travolgente, una grafica sul filo del fotorealismo ed un sistema di combattimento che sembra l’evoluzione del Free Form Fighting System visto in Prince of Persia: Spirito Guerriero. Il risultato? Un titolo must-have, il cui motore grafico si rifa a quello utilizzato da Batman: Arkham Origins, titolo che sostituisce nella nostra suite di benchmarks. Il gioco è ottimizzato per schede video NVIDIA, dato il supporto all’HBAO, all’SMAA e più in generale a tutti i GameWorks dell’azienda. Il gioco, soprattutto alle alte risoluzioni e con i filtri al massimo, richiede un quantitativo di memoria video non indifferente, e pertanto risulta pienamente indicato qualora voleste mettere alla prova schede video con un quantitativo VRAM maggiore:

Test in 4K e overclock–>

Ecco i risultati ottenuti con la scheda alla risoluzione di 3840×2160, per gli amici, 4K:

Considerazioni finali–> [conclusione]

[titolo]Design e qualità costruttiva[/titolo]

Una scheda dal design rinnovato, decisamente più sobrio rispetto alla precedente generazione (la 290X, di cui condivide grosso modo tutte le specifiche, se non la dotazione standard di 8GB di GDDR5 al posto di 4GB), con il nero che la fa da padrona e gli accent dorati che donano quel tocco di originalità che non sfocia nella tamarragine. Il sistema IFC-II (Intelligent Fan Control) spegne le ventole con workload leggeri, permettendo il silenzio assoluto (almeno sul fronte della VGA).

[voto=”10″]

[/conclusione]

[conclusione]

[titolo]Prestazioni e overclock[/titolo]

Guardando le specifiche, e notando che di fatto si tratta di un refresh della 290X, si potrebbe storcere il naso; tuttavia, grazie ai driver 15.15 (unicamente supportati dalla serie 300) e al “bump” nelle frequenze (25MHz sulla GPU e ben 1 GHz sulle VRAM), la R9 390X riesce ad incrementare le prestazioni del 5-10% rispetto alla serie precedente, insidiandosi tra la GTX970 e la GTX980, con un prezzo però più vicino alla prima. Il sample ci è arrivato con un giorno di ritardo, e pertanto pur di pubblicare la recensione quanto prima possibile non abbiamo effettuato overclock, ma visto che la scheda, con una frequenza di 1055MHz sulla GPU e di 6100MHz sulle RAM, consuma quanto la 290X a 1000/1250, non possiamo che aspettarci un bel po’ di headroom grazie all’efficienza migliore dovuta alle rese dei wafer di silicio, in produzione ormai da più di due anni per questa GPU.

[voto=”9″]

[/conclusione]

[conclusione]

[titolo]Compatibilità e consumi[/titolo]

Sul fattore compatibilità, la scheda dispone di connessione PCI-E 16x di tipo 3.0, retrocompatibile con lo standard 2.0 (non è assicurata la compatibilità su schede madri con connessione PCI-E 16x di prima generazione), mentre da lato alimentatore è suggerito dall’azienda un alimentatore da almeno 600W. Visti i consumi rilevati dalla scheda (circa 250W) potrete optare anche per una soluzione leggermente inferiore, come ad esempio un PSU da 500W. Qualora voleste configurare le schede in CFX a 2 vie, suggeriamo l’utilizzo di un alimentatore da almeno 800W, in modo da non escludere l’overclock dall’equazione. Salite di circa 280W per ogni scheda che vorrete aggiungere al sistema a multi-GPU, fino ad un massimo di 4 schede in parallelo.

[voto=”9″]

[/conclusione]

[conclusione]

[titolo]Prezzo[/titolo]

La Sapphire R9 390X Tri-X OC da 8GB è disponibile ad un prezzo di 469€ presso ePrice, costando di fatto almeno 30€ meno della 290X 8GB che va a sostituire e presentando in media il 5-10% di prestazioni in più rispetto a quest’ultima. Vi invitiamo ad acquistare presso i rivenditori ufficiali Sapphire, in quanto pur presentando un prezzo superiore ai VAT Player (coloro che evadono l’iva tramite meccanismi al limite della legalità), forniscono supporto post-vendita/RMA, cosa che suddetti rivenditori non ufficiali non garantiscono.

[voto=”9″]

[/conclusione]

In definitiva, la Sapphire Radeon R9 390X 8GB è una scheda fresca (sia per il fattore novità sia per il dissipatore estremamente performante)

|

|

Per oggi è tutto da Hades, non dimenticate di seguirci sui nostri social network:

La recensione

Sapphire Radeon R9 390X Tri-X 8GB

Una scheda che rende pan per focaccia alla concorrenza, con un prezzo più aggressivo e features esclusive: la Sapphire Radeon R9 390X Tri-X 8GB presenta un look tutto nuovo e prestazioni superiori alla generazione precedente. Di fronte a voi, la scheda video più veloce di AMD, almeno fino al lancio delle VGA serie Fury.

Pro

- Ideale per 1440p

- Design elegante e più sobrio rispetto alla generazione precedente di VGA Sapphire

- Costa meno della scheda che va a sostituire

Contro

- Consumi superiori alla concorrenza

Sapphire Radeon R9 390X Tri-X 8GB Prezzi

Raccogliamo informazioni da vari negozi per indicare il prezzo migliore